我们有激动人心的消息!PyTorch 2.4 现在支持英特尔®数据中心 GPU Max 系列和 SYCL 软件堆栈,使您能够更轻松地加速 AI 工作流程,包括训练和推理。此更新允许您在最小编码努力的情况下获得一致的编程体验,并扩展 PyTorch 的设备和运行时功能,包括设备、流、事件、生成器、分配器和守卫,以无缝支持流式设备。此增强简化了在通用硬件上部署 PyTorch 的过程,使您能够更容易地集成不同的硬件后端。

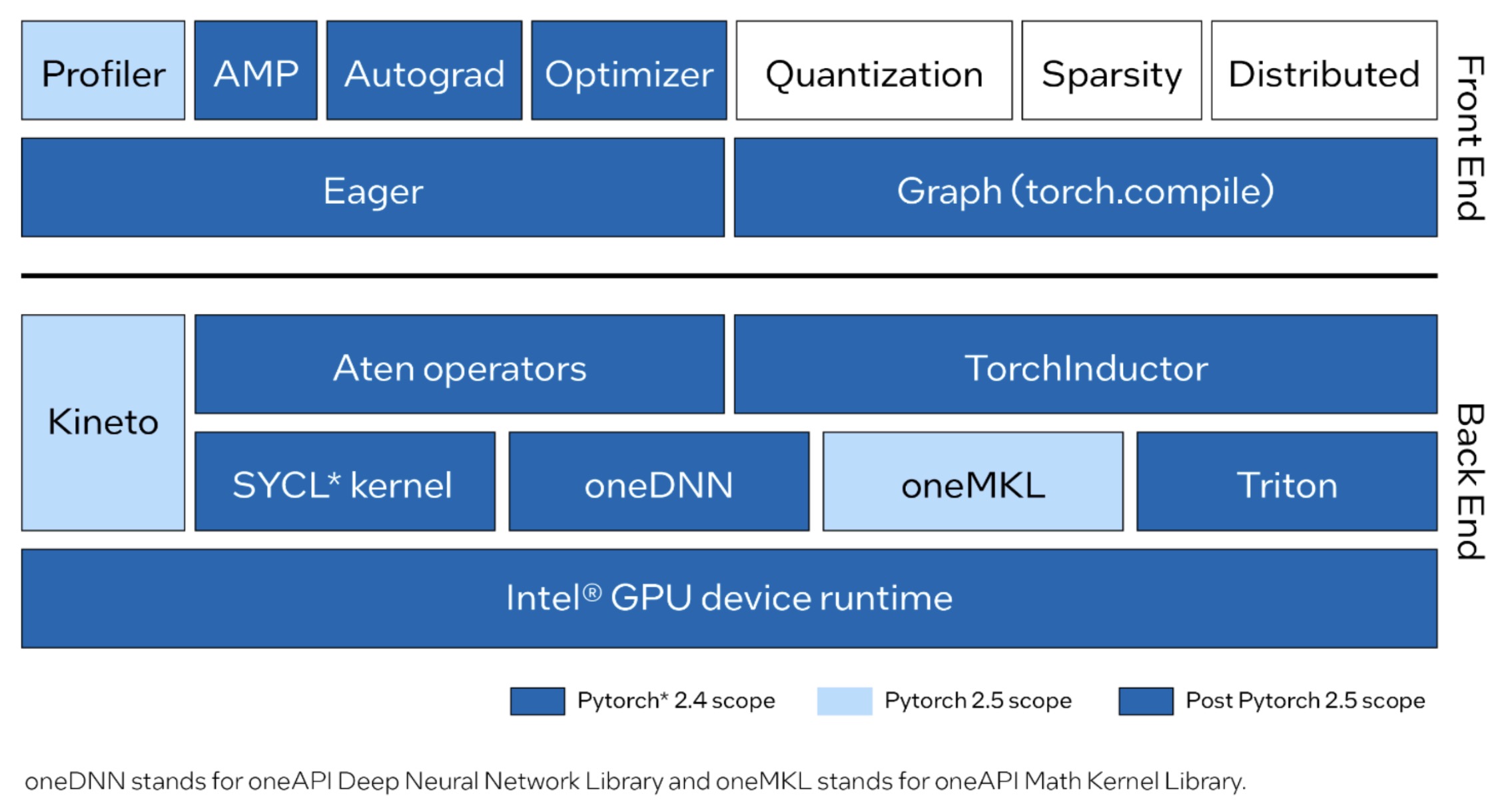

将 Intel GPU 支持集成到 PyTorch 中,为急切模式和图模式提供支持,完全运行 Dynamo Hugging Face 基准测试。急切模式现在包括使用 SYCL 实现的常见 Aten 运算符。最关键的性能图和运算符通过使用 oneAPI 深度神经网络库(oneDNN)和 oneAPI 数学内核库(oneMKL)进行高度优化。图模式(torch.compile)现在已启用 Intel GPU 后端以实现 Intel GPU 的优化并集成 Triton。此外,还支持 FP32、BF16、FP16 和自动混合精度(AMP)等数据类型。基于 Kineto 和 oneMKL 的 PyTorch 分析器正在为即将推出的 PyTorch 2.5 版本开发中。

查看集成到 PyTorch 中的 Intel GPU 当前和计划中的前端和后端改进。

PyTorch 2.4 在 Linux 上支持 Intel 数据中心 GPU Max 系列用于训练和推理,同时保持与其他硬件相同的用户体验。如果您正在从 CUDA 迁移代码,可以在 Intel GPU 上以最小更改运行现有应用程序——只需更新设备名称从 cuda 到 xpu 。例如:

# CUDA Code

tensor = torch.tensor([1.0, 2.0]).to("cuda")

# Code for Intel GPU

tensor = torch.tensor([1.0, 2.0]).to("xpu")

开始使用

尝试在英特尔数据中心 GPU 至强系列上通过英特尔®泰伯™开发者云使用 PyTorch 2.4。了解环境设置、源构建和示例。要了解如何创建免费标准账户,请参阅“入门”,然后执行以下操作:

-

登录云控制台。

-

在“训练”部分打开 PyTorch 2.4 在英特尔 GPU 上的笔记本。

-

确保笔记本已选择 PyTorch 2.4 内核。

摘要

PyTorch 2.4 首次支持英特尔数据中心 GPU Max 系列,以加速您的 AI 工作负载。使用英特尔 GPU,您将获得持续的软件支持、统一的分发和同步的发布计划,以获得更流畅的开发体验。我们正在增强这一功能,使其在 PyTorch 2.5 中达到 Beta 质量。2.5 版本计划中的功能包括:

-

在 Eager Mode 中添加更多 Aten 算子,并完全支持 Dynamo Torchbench 和 TIMM。

-

在 torch.compile 中完全支持 Dynamo Torchbench 和 TIMM 基准测试。

-

torch.profile 中支持英特尔 GPU。

-

PyPI 轮子发行版。

-

支持 Windows 和英特尔客户端 GPU 系列。

我们欢迎社区评估这些针对 PyTorch 的英特尔 GPU 支持的新贡献。

资源

致谢

我们要感谢 PyTorch 开源社区在技术讨论和见解方面的贡献:Nikita Shulga、Jason Ansel、Andrey Talman、Alban Desmaison 和 Bin Bao。

我们还要感谢 PyTorch 团队的合作伙伴们给予的专业支持和指导。

1 要启用 GPU 支持,并提高性能,我们建议安装 Intel® 对 PyTorch 的扩展