PReLU¶

- class torch.nn.PReLU(num_parameters=1, init=0.25, device=None, dtype=None)[source][source]¶

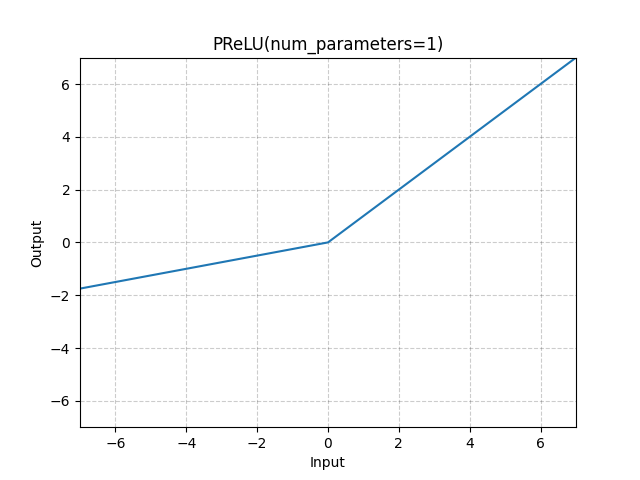

应用逐元素 PReLU 函数。

或者

是一个可学习的参数。当不带参数调用 nn.PReLU() 时,它使用单个参数 涵盖所有输入通道。如果使用 nn.PReLU(nChannels) 调用,则每个输入通道使用单独的 。

注意

为了获得良好的性能,学习 时不应使用权重衰减。

注意

通道维度是输入的第二个维度。当输入维度小于 2 时,则没有通道维度,通道数等于 1。

- 参数:

num_parameters (int) – 要学习的 的数量。虽然它接受 int 类型的输入,但只有两个值是合法的:1 或输入通道的数量。默认:1

init (float) – 的初始值。默认:0.25

- 形状:

Input: 其中 * 表示任意数量的附加维度。

输出: ,与输入具有相同的形状。

- 变量:

weight (Tensor) – 形状为 (

num_parameters) 的可学习权重。

示例:

>>> m = nn.PReLU() >>> input = torch.randn(2) >>> output = m(input)